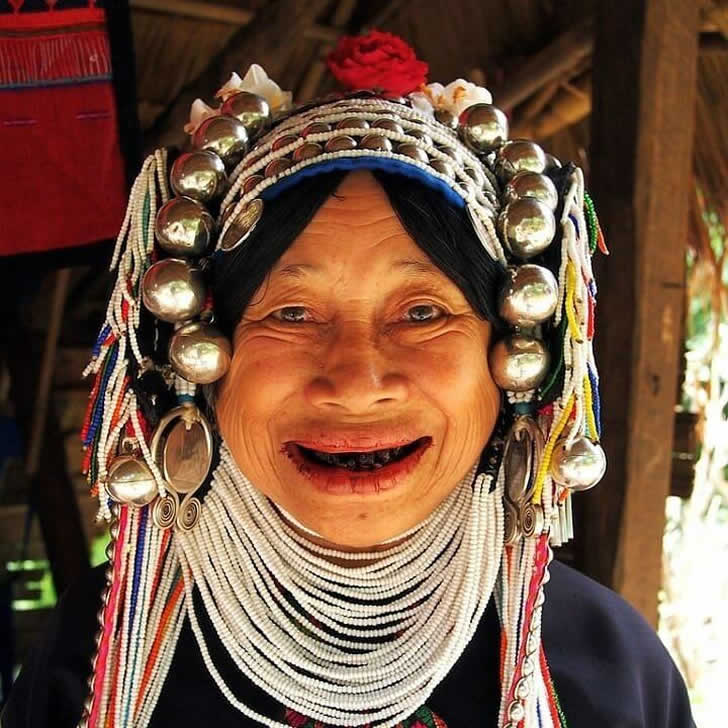

Les dents noires étaient considérées comme belles

Dans certaines régions du Japon et d’Asie du Sud-Est, les dents noires étaient autrefois considérées comme un idéal de beauté. Les gens se teignaient les dents avec un vernis spécial qui servait également de conservateur contre les caries et la pourriture.

Même si cela peut paraître étrange ou effrayant aux yeux modernes, les dents noircies symbolisaient alors la santé, l’élégance et la maturité. Cette tradition a largement disparu, mais elle est encore pratiquée dans certaines petites communautés.