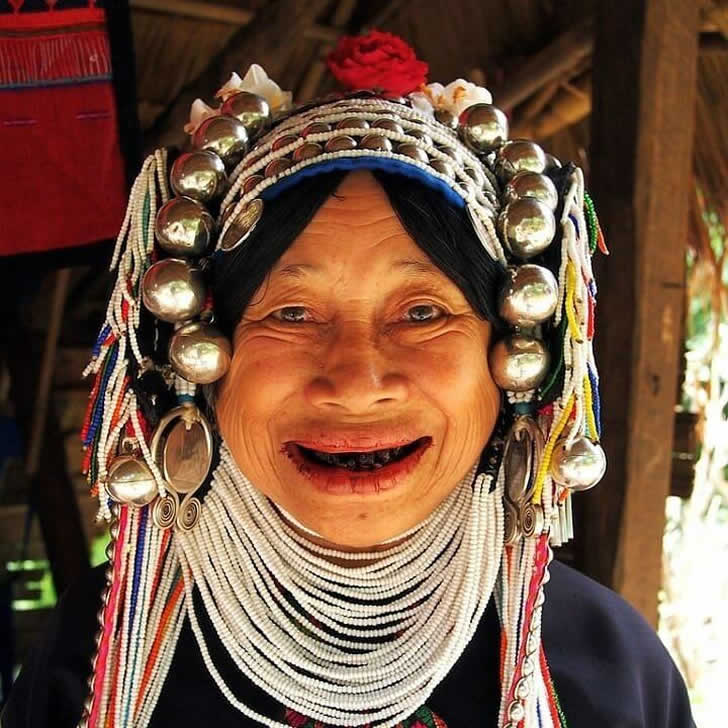

Noircir ses dents était considéré comme un signe de beauté

Dans certaines régions du Japon et d’Asie du Sud-Est, les dents noires étaient autrefois un critère de beauté très prisé. Les gens se teintaient les dents avec un vernis spécial qui agissait également comme un agent de conservation, empêchant la pourriture et la carie.

Bien que cela puisse paraître étrange ou effrayant aux yeux modernes, les dents noircies symbolisaient la santé, l’élégance et la maturité. Cette tradition s’est largement estompée, mais de petites communautés honorent encore cette coutume unique aujourd’hui.

Advertisements

Advertisements