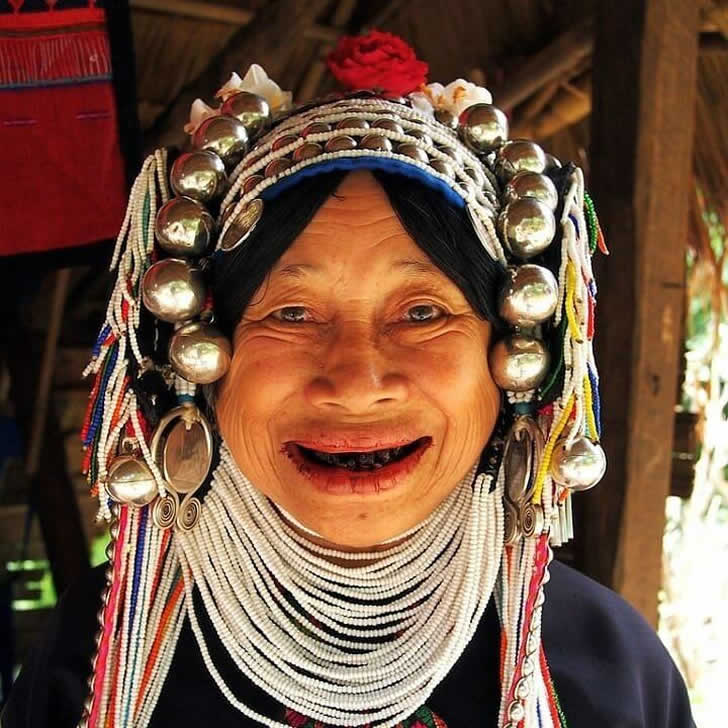

Avere i Denti Neri Era Considerato un Segno di Bellezza

In alcune zone del Giappone e del Sud-est asiatico, i denti neri erano un tempo considerati un canone di bellezza. Le persone si tingevano i denti con una vernice speciale che fungeva anche da conservante, prevenendo carie e deterioramento.

Anche se potrebbe sembrare strano o inquietante agli occhi moderni, i denti anneriti simboleggiavano salute, eleganza e maturità. La tradizione è per lo più svanita, ma piccole comunità onorano ancora oggi questa usanza unica.